大模型落地实战指南 从选择到训练,打造AI应用新篇章

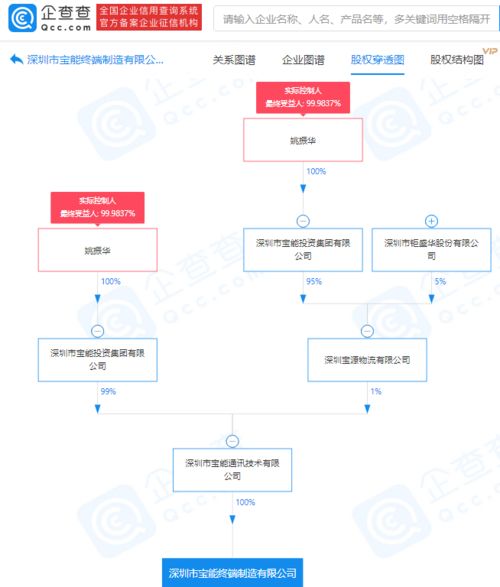

随着人工智能技术的飞速发展,大模型已成为推动各行各业数字化转型的关键工具。大模型的落地并非易事,涉及硬件选型、模型训练与选择等多个复杂环节。本指南将从实战角度出发,深度解析大模型落地的核心步骤,涵盖显卡选型、模型训练技巧、模型选择策略,并对AI未来进行展望,助力计算机软硬件及外围设备制造企业打造高效的AI应用。

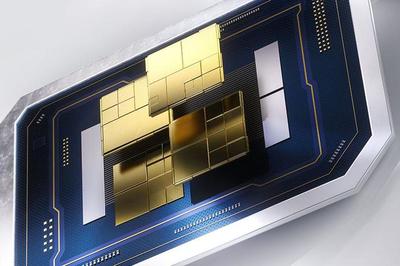

一、显卡选型:硬件基础决定模型性能

在大模型落地过程中,显卡作为计算核心,直接影响训练速度和推理效率。选择合适的显卡需综合考虑算力、显存、功耗和成本。目前,NVIDIA的A100、H100等专业级显卡因其强大的并行计算能力和优化的软件生态成为首选。对于预算有限的企业,RTX 4090等消费级显卡也可作为替代方案,但需注意显存限制。关键指标包括:FP32/FP16算力、显存容量(建议至少24GB以上)、互联带宽(如NVLink)。应结合具体应用场景:例如,图像处理任务可能更依赖高显存,而自然语言处理则需要高算力支持。

二、模型训练技巧:高效优化与数据管理

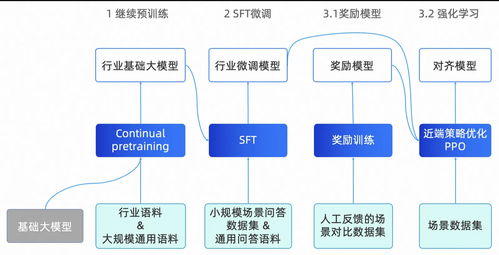

模型训练是大模型落地的核心环节。数据预处理至关重要:需确保数据质量,进行清洗、标注和增强,以提升模型泛化能力。采用分布式训练策略可加速过程,例如使用Horovod或PyTorch DDP框架,结合多GPU并行。超参数调优也不容忽视,可通过网格搜索或贝叶斯优化方法找到最佳学习率、批大小等。迁移学习能大幅减少训练时间和资源消耗,例如基于预训练模型(如BERT、GPT系列)进行微调。监控训练过程,使用TensorBoard等工具可视化损失和准确率,及时调整策略以避免过拟合。

三、模型选择巧:匹配业务需求与资源约束

模型选择直接影响应用效果和成本。企业需根据业务场景(如语音识别、图像分类或文本生成)选择合适的大模型。例如,GPT系列适用于生成任务,而ViT模型在计算机视觉领域表现优异。关键考虑因素包括:模型大小(参数量)、推理延迟、准确率和可解释性。对于资源受限的环境,可优先选择轻量化模型(如MobileNet或TinyBERT),或通过模型剪枝、量化技术压缩模型。评估开源模型与自研模型的利弊:开源模型(如Hugging Face提供的模型)可快速部署,但自研模型更能满足定制化需求。

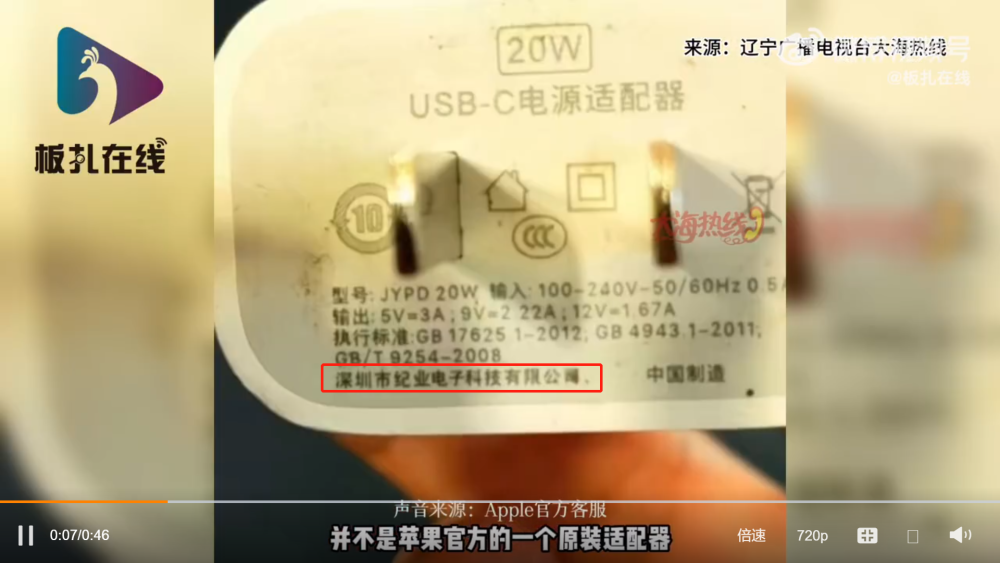

四、AI未来展望:技术趋势与行业应用

AI技术正朝着多模态、自适应和可解释性方向发展。大模型将更注重跨领域融合,例如结合视觉与语言的多模态模型(如DALL·E)。在硬件方面,专用于AI的芯片(如TPU、NPU)将普及,提升能效比。对于计算机软硬件及外围设备制造业,AI可用于优化生产流程(如预测性维护)、提升产品质量(如自动检测缺陷),并推动智能设备(如AI摄像头、机器人)的创新。伦理与法规也将成为焦点,企业需关注数据隐私和模型公平性,以实现可持续发展。

打造AI应用新篇章

大模型落地是一个系统工程,需硬件、软件和数据的协同。通过科学选型显卡、优化训练流程和精准选择模型,企业可降低门槛,加速AI应用部署。随着技术演进,AI将为计算机软硬件及外围设备制造带来革命性变革,开启智能化新篇章。建议企业持续学习最新技术,构建跨学科团队,以应对未来挑战。

如若转载,请注明出处:http://www.jingxin-keji.com/product/8.html

更新时间:2026-01-15 15:49:32